图神经网络(GNNs)是图表示学习的有力工具。尽管GNNs发展迅速,但也面临一些挑战,如过拟合、过平滑和非鲁棒性等。已有的工作表明,这些问题可以通过随机丢弃的方法来得到缓解,这些方法通过随机掩盖部分输入将噪声整合到模型中。然而,即便如此有关GNNs随机丢弃的一些开放性问题仍有待解决。首先,考虑到不同数据集和模型的差异性,寻找一种适用于所有情况的通用方法具有挑战性。其次,GNNs中引入的随机噪声会导致参数覆盖不完全和训练过程不稳定。

2023年2月7日,浙江大学计算机学院杨洋团队在全球人工智能顶会AAAI 2023发表题为“DropMessage: Unifying Random Dropping for Graph Neural Networks”的研究成果,并获得“杰出论文奖”(Distinguished Paper Award)的荣誉。本次投稿的论文脱颖而出,得益于该团队一直以来在计算机图数据和图神经网络领域深厚的创新力。该研究提出了一种基于message-passing图神经网络的随机删减方法——DropMessage,并理论性地证明了现有的随机删减方法都可以看成是DropMessage的特殊形式。相比于现有方法,DropMessage还有收敛速度快、训练过程稳定和保留更多信息的优势。研究认为应用DropMessage可以普适地提升基于message-passing的图神经网络的性能。

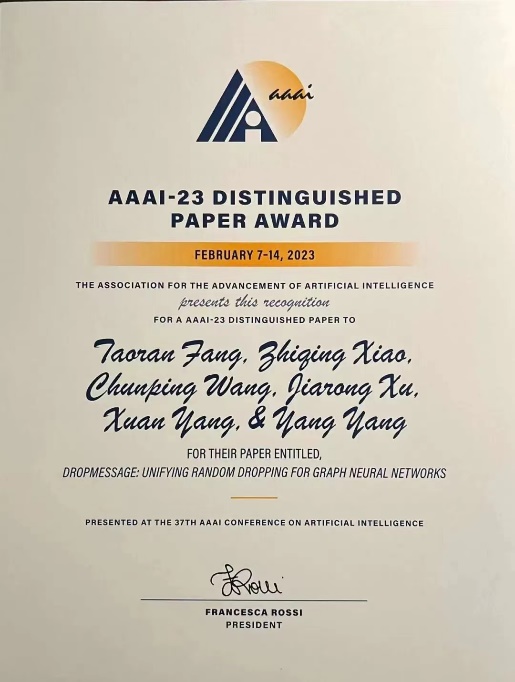

随机删减方法指的是在神经网络模型上一层输出和下一层输入之间随机删除部分元素的一类方法。这类方法能够广泛提升模型的鲁棒性和泛化性,几乎所有的深度模型都会应用这一方法来提升模型性能。针对近年来得到广泛研究的图神经网络,已有诸多随机删减方法的变体被提出,其中包括DropEdge,DropNode。这些变体与传统的Dropout一起被应用到众多GNNs模型。该研究工作针对图神经网络的消息传递机制(message-passing),提出了在消息层面进行随机删减的DropMessage方法。它是更加细粒度的图上随机删减方法,现有的随机删减方法都是DropMessage的特殊形式。而相比于现有方法,DropMessage的样本方差更小,保留了图上信息的多样性。这一工作在理论和实验两个层面上都证明了DropMessage方法的优越性。

图示:DropMessage示意图

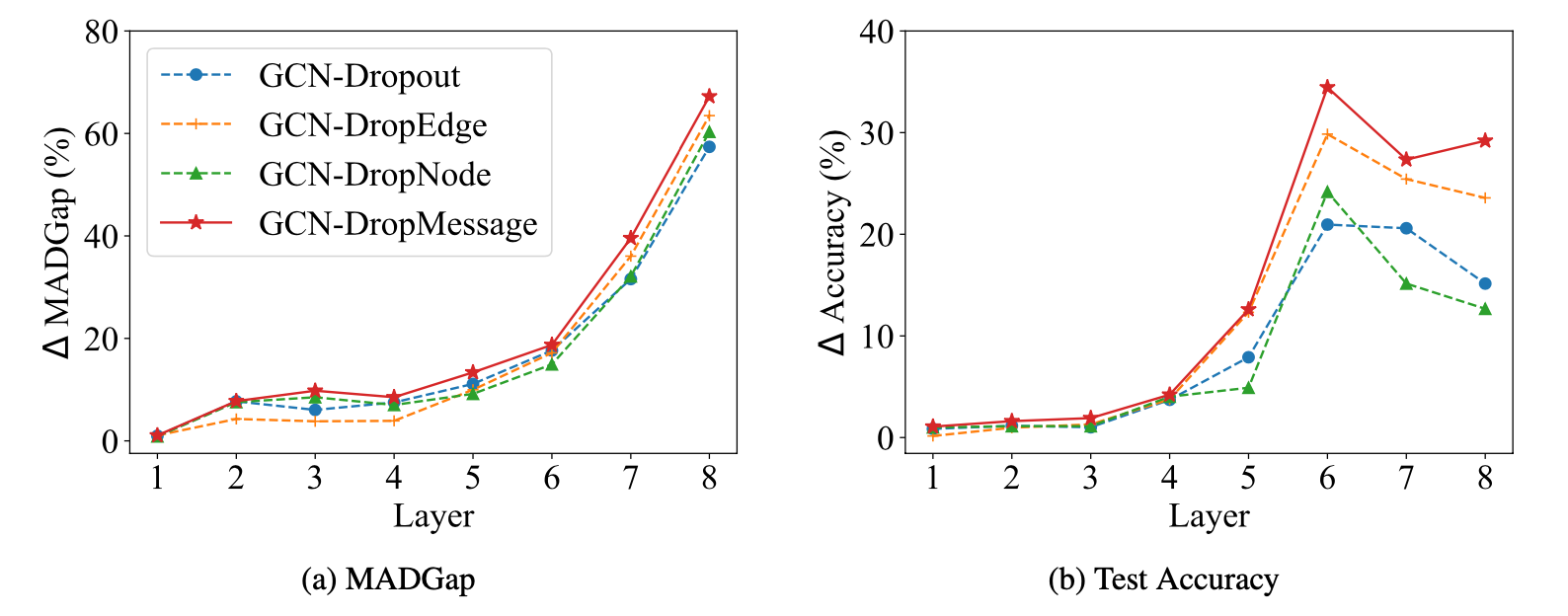

研究首先给出了随机删减方法在GNNs上有效性的理论证明。

随后证明了由于随机删减方法会在模型损失函数中引入额外的正则约束,进而使得模型更加鲁棒。研究发现,相较于其它方法,DropMessage的确具有降低样本方差和保证信息多样性等优势。此外,该研究在多个数据上进行了性能实验,结果表明DropMessage相比于其他方法有着一定的性能提升效果,并且能够更好地避免模型产生过拟合。

图示:过拟合分析

上述研究成果已被全球人工智能顶会AAAI 2023会议论文收录,浙江大学计算机学院为论文第一作者单位。计算机学院博士生方陶然为第一作者,杨洋副教授为通讯作者,浙江大学计算机学院博士生萧芷晴、硕士生杨萱、信也科技王春平博士、复旦大学副研究员许嘉蓉为共同作者。本研究受到国家自然科学基金、国家重点研发项目计划、中央高校基本科研专项资金资助。

原文链接:https://arxiv.org/abs/2204.10037

代码链接:https://github.com/zjunet/DropMessage